در جلسات پیش بلوک سئو آموختید سئو چیست و الگوریتمهای گوگل که بر روی سئوی سایت اثر دارند بررسی شدند. همان طور که پیش از این گفته شد، یکی از بخشهای مهم که باید در سئوی سایت به آن توجه کرد سئو تکنیکال یا سئو فنی است.

سئو تکنیکال به موارد فنی سایت شما اشاره دارد که بر روی ورودی گرفتن از جستجوی ارگانیک اثر دارند؛ مانند معماری سایت، بهینه بودن نسخه موبایل و سرعت سایت. این جنبه سئو ممکن است چندان به چشم نیایند، اما نتایج آن بسیار باورنکردنی است.

اولین قدم در بهبود سئو تکنیکال این است که بدانید وضعیت فعلی سایت چگونه است. مرحله دوم برنامهریزی برای پیادهسازی اصول سئو تکنیکال است که آن را قدم به قدم بررسی میکنیم.

سئو تکنیکال مربوط به هر اقدامی است که کراول کردن (crawl) و ایندکس کردن (index) سایت را برای موتورهای جستجو آسانتر میکند. در مرحله کراول کردن هر موتور جستجو از رباتهای خود استفاده میکند تا صفحات جدید و تغییرات جدید را شناسایی کنند. رباتهای گوگل در ابتدا با چند صفحه از سایت فرایند کراول کردن را شروع میکنند. به اصطلاح رباتهای خزنده این کار را انجام میدهند و سپس از طریق لینکها، URL جدید را شناسایی میکنند. اطلاعات شناسایی شده توسط رباتها ذخیره میشوند و مانند کتاب در کتابخانه به صورت طبقهبندی شده نشانهگذاری یا ایندکس میشوند. سئوی تکنیکال، استراتژی محتوا و استراتژی لینکسازی همه در کنار یکدیگر به رتبه گرفتن سایت شما کمک میکنند.

بسیاری افراد سئوی فنی را نادیده میگیرند ولی نقشی که سئو تکنیکال برای دریافت ترافیک ارگانیک ایفا میکند، بسیاری بااهمیت است. ممکن است محتوای شما بهترین نوشته باشد اما اگر به درستی کراول نشود، افراد کمی آن را خواهند دید.

اگر سایت شما از نظر فنی بهینه نباشد، گوگل آن را نمیبیند و در صفحه نتایج گوگل دیده نمیشوید و از این راه ورودی کمی خواهید گرفت. بنابراین باید بدانید که چگونه میتوان محتوای خود را از طریق اینترنت منتشر کرد و برای این منظور بهتر است به مرجع معتبر آموزش سئو مراجعه نمایید تا پس از یادگیری خودتان اقدام به بهینه سازی سایت کنید.

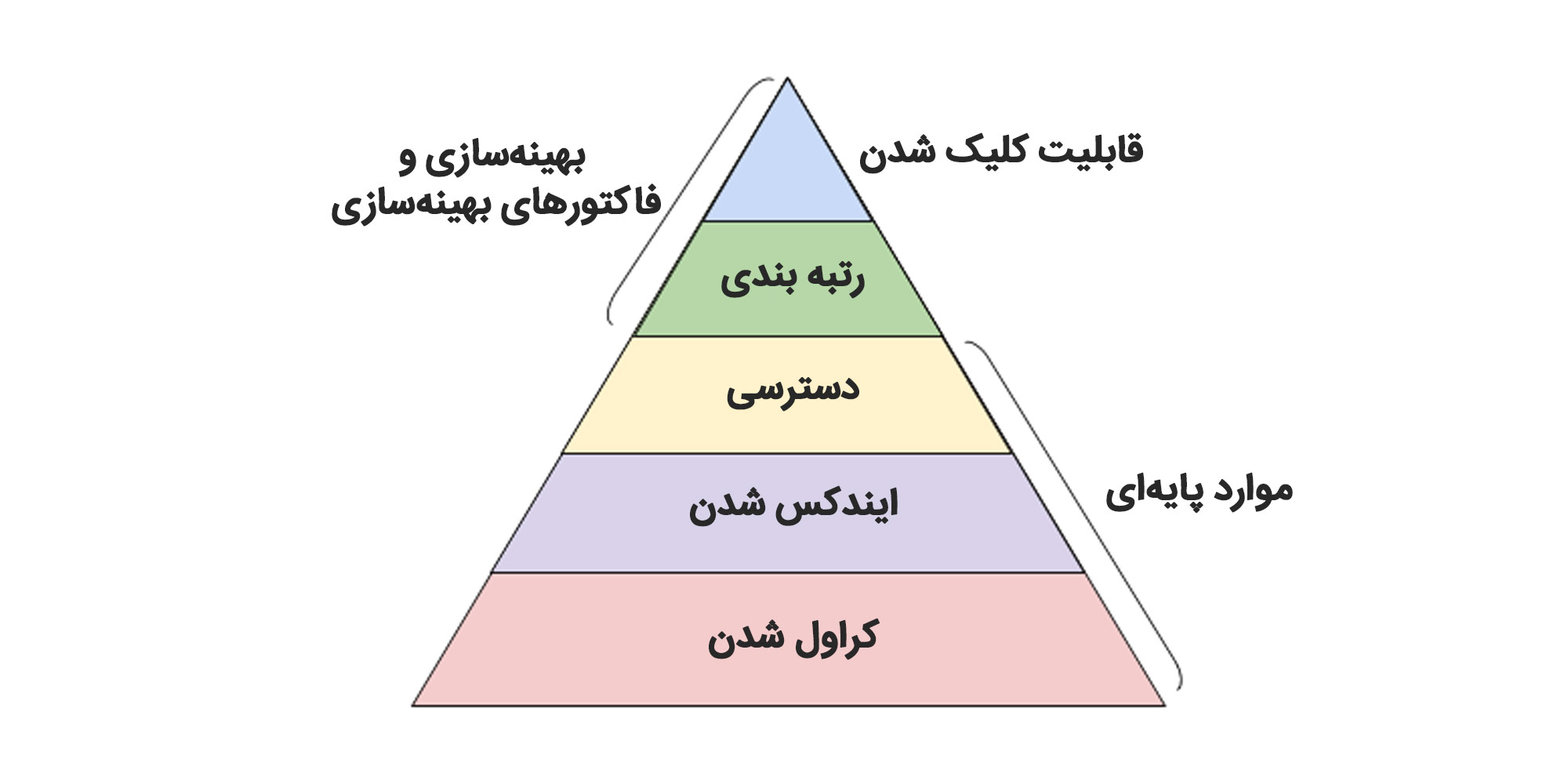

سئوی تکنیکال چند بخش دارد که میتوان آن را جداگانه بررسی کرد. به طور کلی میتوان اقدامات سئوی فنی را در ۵ دسته کلی جای داد. این اقدامات در هرم زیر نشان داده شدهاست. ترتیب انجام اقدامات از طبقات زیرین به سمت طبقات بالا است.

قبل از شروع به کار بر روی سئوی فنی سایت، چند اصل اساسی وجود دارد که باید آنها را اجرا کنید. قبل از پرداختن به دیگر موارد فنی وبسایت، این اصول را توضیح میدهیم.

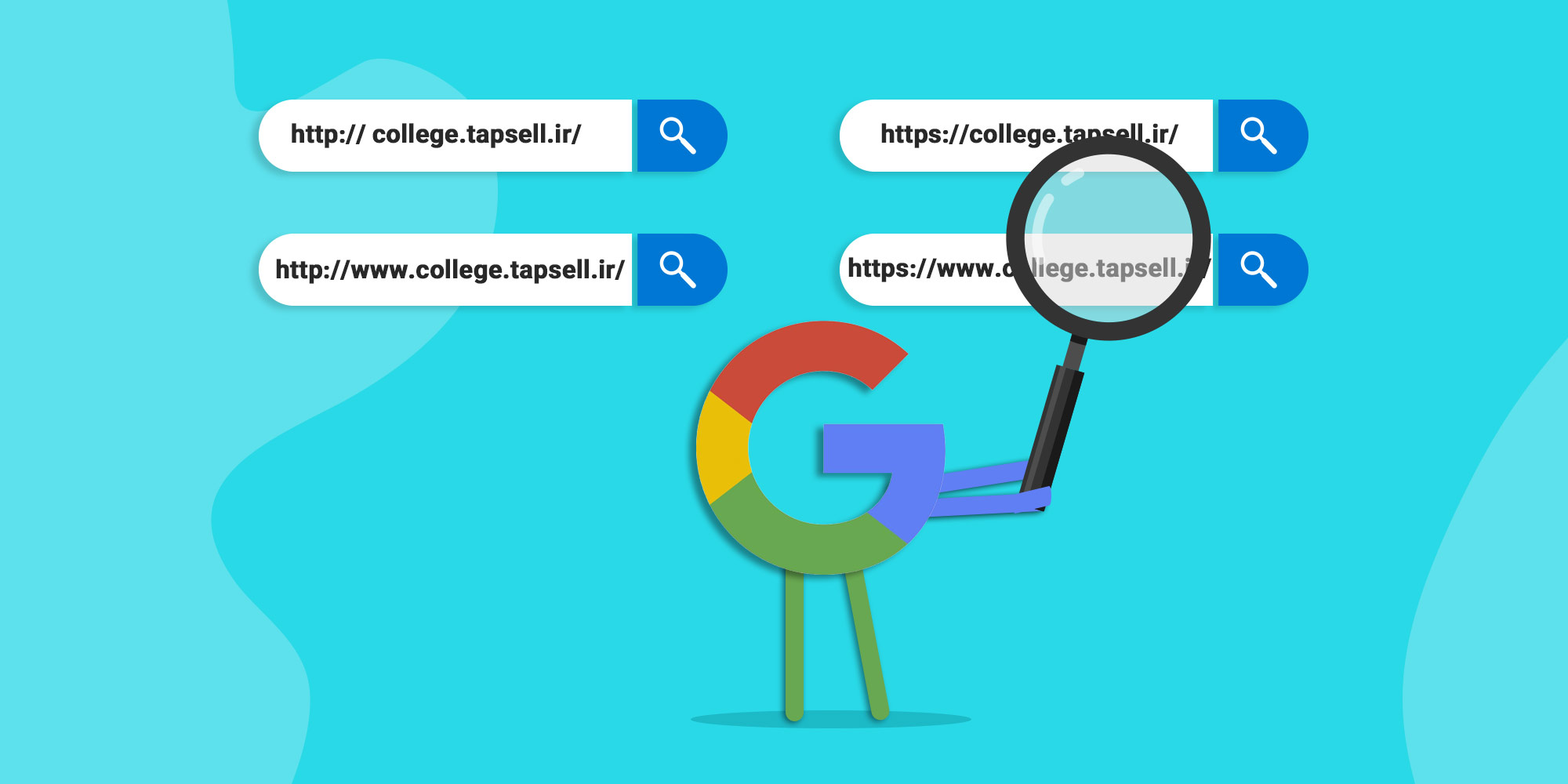

دامنه شما URL است که افراد برای ورود به سایت شما، مانند college.tapsell.com، تایپ میکنند. دامنه وبسایت روشی ثابت برای شناسایی سایت شما را فراهم میکند.

وقتی دامنه مورد نظر خود را انتخاب میکنید، به موتورهای جستجو میگویید که آیا ترجیح میدهید نسخه www یا غیر www سایت شما در نتایج جستجو نمایش داده شود. به عنوان مثال، شما ممکن است www.college.tapsell.ir را به عنوان دامنه منتخب وب سایت خود انتخاب کنید. این امر به موتورهای جستجو امکان میدهد كه نسخه www سایت شما را در اولویت قرار دهند و همه كاربران را در آن URL هدایت كنید. در غیر این صورت موتورهای جستجو با این دو نسخه به صورت سایتهای جداگانه برخورد میکنند و در نتیجه ارزش سئویی آن صفحه پراکنده میشود. البته اخیرا خود گوگل نسخهای از سایت را برای نمایش جستجوگرها برای شما شناسایی و انتخاب میکند.

با این حال، اگر ترجیح می دهید نسخه مورد نظر URL خود را تنظیم کنید، می توانید این کار را از طریق تگ کنونیکال یا canonical tag انجام دهید. تگ کنونیکال از تگهای HTML است که در صورت قرار گرفتن محتوای مشابه در صفحات گوناگون میتوان با تگ کنونیکال نسخه اصلی را مشخص کنید تا این صفحه در گوگل ایندکس شود.

SSL یا Secure Sockets Layer یک لایه محافظ بین سرور وب و یک مرورگر ایجاد میکند و از این طریق سایت شما ایمن میشود.

تغییر آدرس سایت به HTTPS: پس از تنظیم SSL، باید صفحات غیر SSL را از http به https انتقال دهید. برای این کار باید ارزش صفحات قدیم را به صفحات جدید منتقل کنید. برای این کار باید به اصطلاح صفحات قدیم را به صفحات جدید ریدایرکت (redirect) کرد. درباره ریدایرکتها و انواع آن در ادامه توضیح دادهایم.

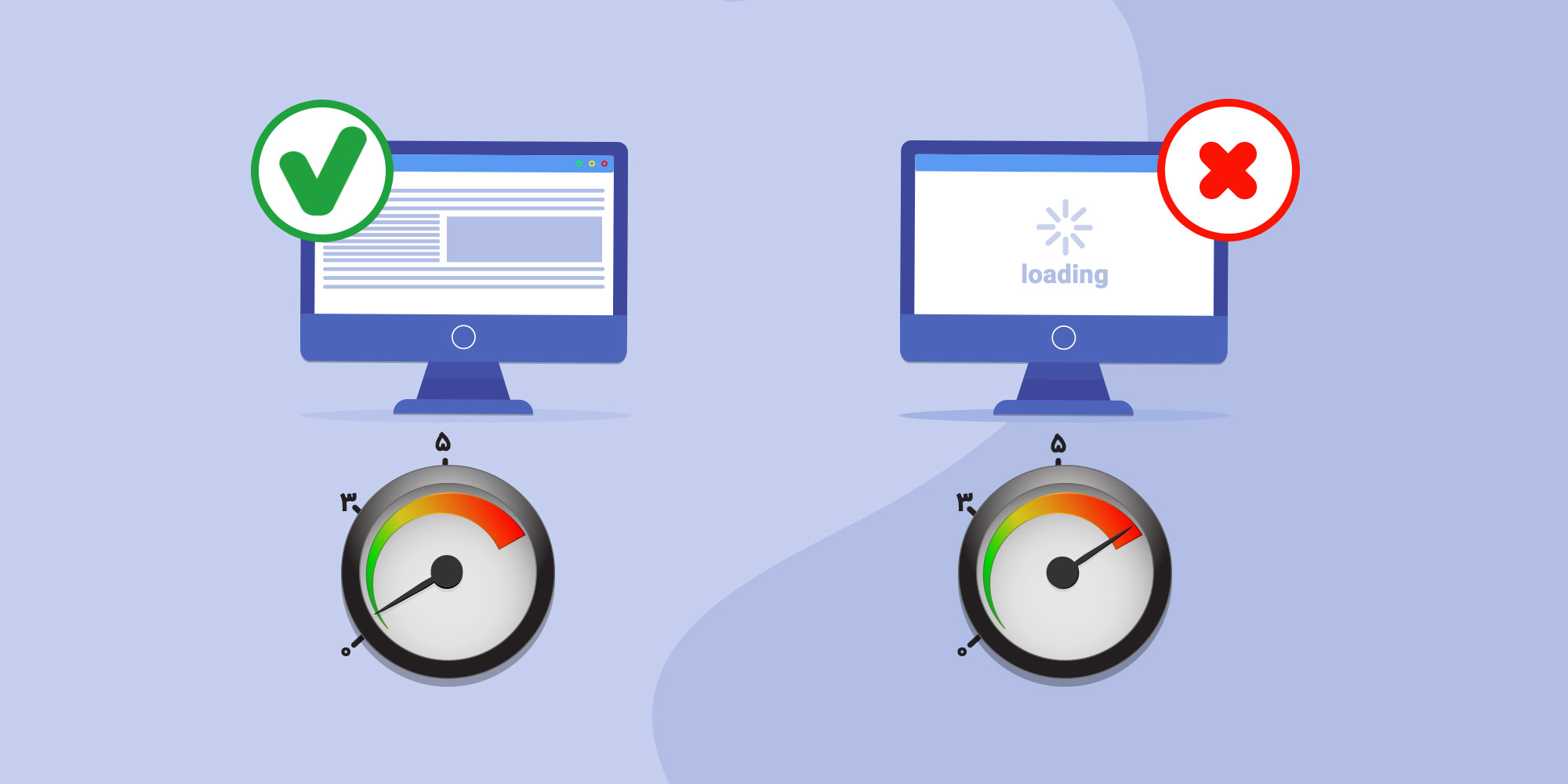

میدانید بازدید کننده وبسایت تا چه مدت منتظر بارگذاری صفحات خواهد بود؟ در بهترین حالت شش ثانیه زمان دارید. برخی آمارها نشان دادهاند که با افزایش سرعت بارگذاری سایت به بیش از ۵ ثانیه، نرخ پرش (bounce rate) به میزان ۹۰ درصد افزایش میابد. بنابراین نه تنها سرعت سایت برای تجربه کاربر مهم است بلکه این یک عامل رتبه بندی نیز هست.

برای رفع مشکل کندی سایت تصاویر را فشرده کنید تا حجم آنها کاهش یابد. برای این کار میتوانید از وبسایتهایی مانند imagecompressor.com استفاده کنید. اما توجه داشته باشید که کیفیت تصاویر شما نباید افت کند یا اگر هم افت کرد جزئی باشد. همچنین استفاده از فرمتهای جدیدتر مثل WebP که به نسبت تصاویر قدیمیتر حجم کمتری دارند، میتواند برای سرعت سایت مفید باشد.

اگر کدهای CSS و JavaScript طولانی و پیچیده باشند، بارگذاری سایت کند میشود. برای افزایش سرعت بارگذاری سایت این کدها را فشردهسازی کنید. همچنین میتوانید بارگذاری این فایلها را به تاخیر بیندازید تا اول محتوای اصلی سایت بارگذاری شود.

ریدایرکت 301 برای پردازش چند ثانیه زمان میبرد و بر سرعت سایت شما تأثیر میگذارد. بنابراین از ریدایرکتهای پیاپی جلوگیری کنید. درباره ریدایرکت ۳۰۱ در ادامه متن توضیح بیشتر خواهیم داد.

کد نامرتب میتواند بر سرعت سایت شما تأثیر منفی بگذارد. کد نامرتب مثل نوشتن است؛ شاید در پیش نویس اول، در 6 جمله نظر خود را بیان کنید. اما در پیش نویس دوم ، آن را در 3 جمله مینویسید که بسیار موثرتر و مرتبتر است. برای کدها نیز همین اتفاق میافتد. هر چه کد کارآمدتر باشد، در صفحه سریعتر بارگذاری میشود.

CDN ها (Content Delivery Network) سرورهای توزیع وب هستند که نسخه کپی وبسایت شما را در مکانهای مختلف جغرافیایی ذخیره میکنند و سایت شما را بر اساس مکان جستجوگر نمایش میدهند. از آنجا که اطلاعات بین CDNها مسافت کمتری برای پیمودن دارند، سایت شما سریعتر بارگذاری میشود. در تصویر زیر شیوه عملکرد شبکه توزیع محتوا یا CDN نمایش داده شده است.

پلاگینهای منسوخ شده اغلب دارای آسیبهای امنیتی هستند که وبسایت شما را در معرض هکرهای مخرب قرار میدهند. این اتفاق میتوانند به رتبه وب سایت شما آسیب برساند. اطمینان حاصل کنید که همیشه از آخرین نسخه های پلاگین استفاده میکنید.

پس از دانستن اصول سئوی تکنیکال سایت، لازم است قابلیت کراول شدن سایت را دقیق بررسی کنیم.

قابلیت کراول کردن سایت، پایه و اساس استراتژی سئوی شما است. رباتها صفحات را بررسی میکنند تا اطلاعات مربوط به سایت شما جمعآوری شود. اگر رباتها نتوانند به درستی به صفحات سایت شما دسترسی داشته باشند، در این صورت سایت شما در صفحه نتایج موتور جستجو نمایش داده نمیشود.

در ادامه برخی موارد مهم که لازم است برای کراول شدن درست سایت مد نظر قرار دهید، ذکر شده است.

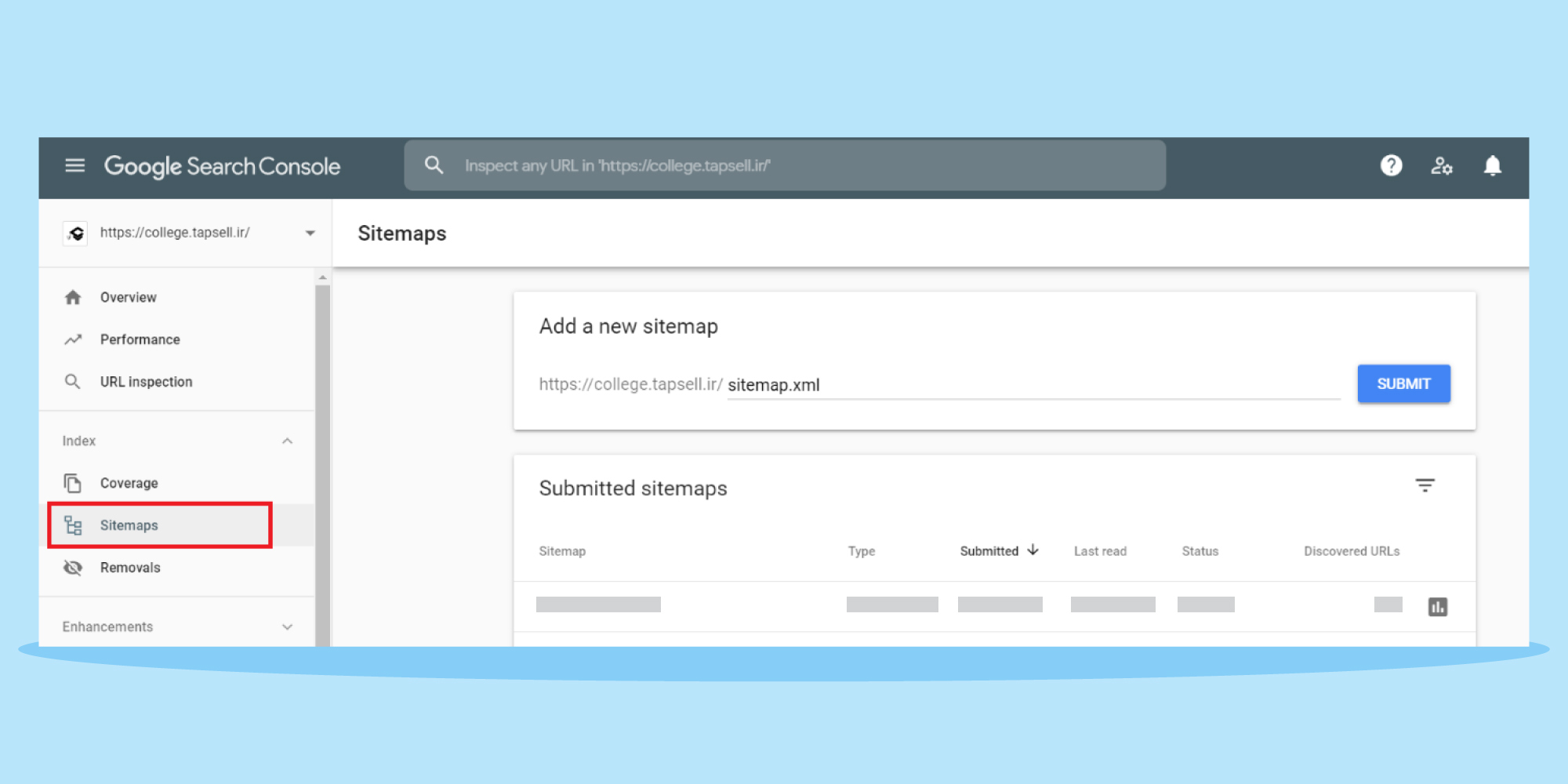

نقشه سایت با فرمت XML به رباتهای موتورهای جستجو ساختار سایت شما و ارتباطات آن را نشان میدهد. باید فایل نقشه سایت را در گوگل سرچ کنسول بارگذاری کنید. نقشه سایت باید به روز شود تا صفحات جدید را نشان دهد. در تصویر زیر بخش مربوط به نقشه سایت در گوگل سرچ کنسول نشان داده شدهاست.

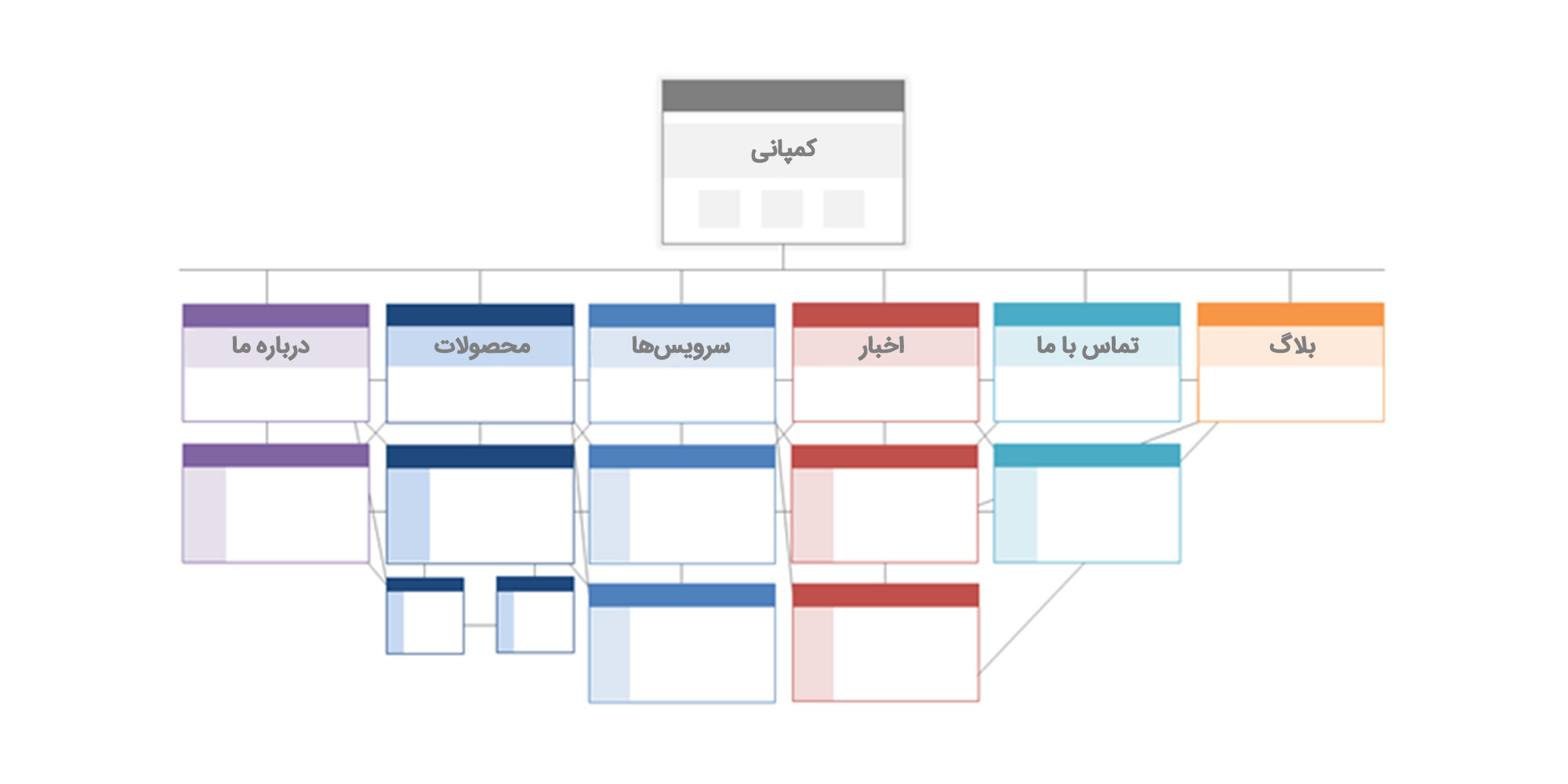

وبسایت شما چندین صفحه دارد. این صفحات باید به شکلی ساماندهی شوند که به موتورهای جستجو اجازه دهند آنها را به راحتی پیدا و کراول کنند. اینجاست که ساختار سایت شما (که معمولاً از آن به عنوان معماری اطلاعات وب سایت شما یاد میشود) اهمیت میابد.

صفحات مرتبط با هم گروهبندی میشوند. به عنوان مثال صفحات مربوط به شبکههای اجتماعی میتوانند در یک دستهبندی قرار بگیرند. علاوه بر این لینکسازی و لینک دادن مطالب مرتبط نیز میتواند به شکلگیری ساختار بهتر سایت کمک کند.

معماری سایت و نحوه شکلگیری ساختار سایت اهمیت صفحات را مشخص میکند. به عنوان مثال، صفحهی فرضی «الف» را در نظر بگیرید. لینک از صفحه اصلی شما به صفحه «الف» اهمیت بیشتری نسبت به لینک یک پست وبلاگ به صفحه «الف» دارد. در کل، هرچه لینک به صفحه «الف» بیشتر باشد، آن صفحه برای موتورهای جستجو با اهمیتتر میشود. از سویی اگر صفحهای در دستهبندی در رده بالا قرار بگیرد، اهمیت بیشتر آن را نشان میدهد.

بنابراین اطمینان حاصل کنید که مهمترین صفحات کسبوکار شما در بالای سلسله مراتب با بیشترین تعداد لینکهای داخلی مرتبط قرار داشته باشند.

ساختار URL میتواند از طریق معماری سایت شما تعیین شود. در ادامه چند نکته در مورد نحوه نوشتن URL شما آورده شده است:

پس از تنظیم ساختار URL خود، لیستی از URLهای صفحات مهم را در قالب نقشه سایت با فرمت XML به موتورهای جستجو ارسال میکنید. انجام این کار به رباتهای موتورهای جستجو اطلاعات اضافه پیرامون موضوع محتوا میدهد.

ساختار URL میتواند به دو صورت ساب دامین (SubDomains) مانند blog.hubspot.com یا به صورت ساب دایرکتوری (subDirectory) مانند hubspot.com/blog بیاید که بستگی به محتوای شما دارد. در صورتی که محتوای شما به عنوان سایت جداگانه میتواند ارائه شود، استفاده از ساب دامین گزینه مناسبی برای شما است.

وقتی یک روبات وبسایت شما را کراول میکند، ابتدا فایل robots.txt را چک مینماید. این پروتکل میتواند به روباتهای وب اجازه دهد یا اجازه ندهد که بخشهایی از سایت شما را بررسی کنند. اگر می خواهید از ایندکس شدن سایت های خود جلوگیری کنید، از یک متا ربات noindex استفاده کنید. ممکن است بخواهید برخی صفحات خود را ایندکس نکنید و دسترسی کراولر را به طور کلی مسدود کنید. این کار با robots.txt انجام میگیرد.

با توجه به ایندکس کردن صفحات، رباتهای جستجو سایت شما را برای جمعآوری سرنخها و یافتن کلمات کلیدی بررسی میکنند تا بتوانند صفحات وب شما را با جستجوی مربوطه جستجو کنند. اما، سایت شما بودجه کراول شدن دارد که بهتر است آن را برای صفحات کمارزش صرف نکنید. بنابراین، شما ممکن است بخواهید صفحاتی را که به رباتهای جستجو برای شناخت موضوع شما کمک نمیکنند را حذف کنید.

داستان قدیمی هانسل و گرتل که در آن دو کودک نان سوخاری را روی زمین انداختند تا راه برگشت به خانه را پیدا کنند را یادتان هست؟ عبارت breadcrumb یا خرده نان نیز برای راهنمایی کاربران و موتورهای جستو ایجاد شدهاست تا ارتباط صفحه سایت با دیگر قسمتهای سایت را نشان دهند. در تصویر زیر بردکرامب در سایت کالج تپسل نشان دادهشده است.

Breadcrumbs باید دو ویژگی داشته باشد:

1) برای کاربران قابل مشاهده باشد تا بتوانند بدون استفاده از دکمه برگشت (Back)، به راحتی بین صفحات وبسایت شما هدایت شوند.

2) از دادههای ساختار یافته که به رباتهای موتورهای جستجو میکند تا متوجه موضوع شود استفاده نمایید. این کد در سایت schema.org در دسترس هستند.

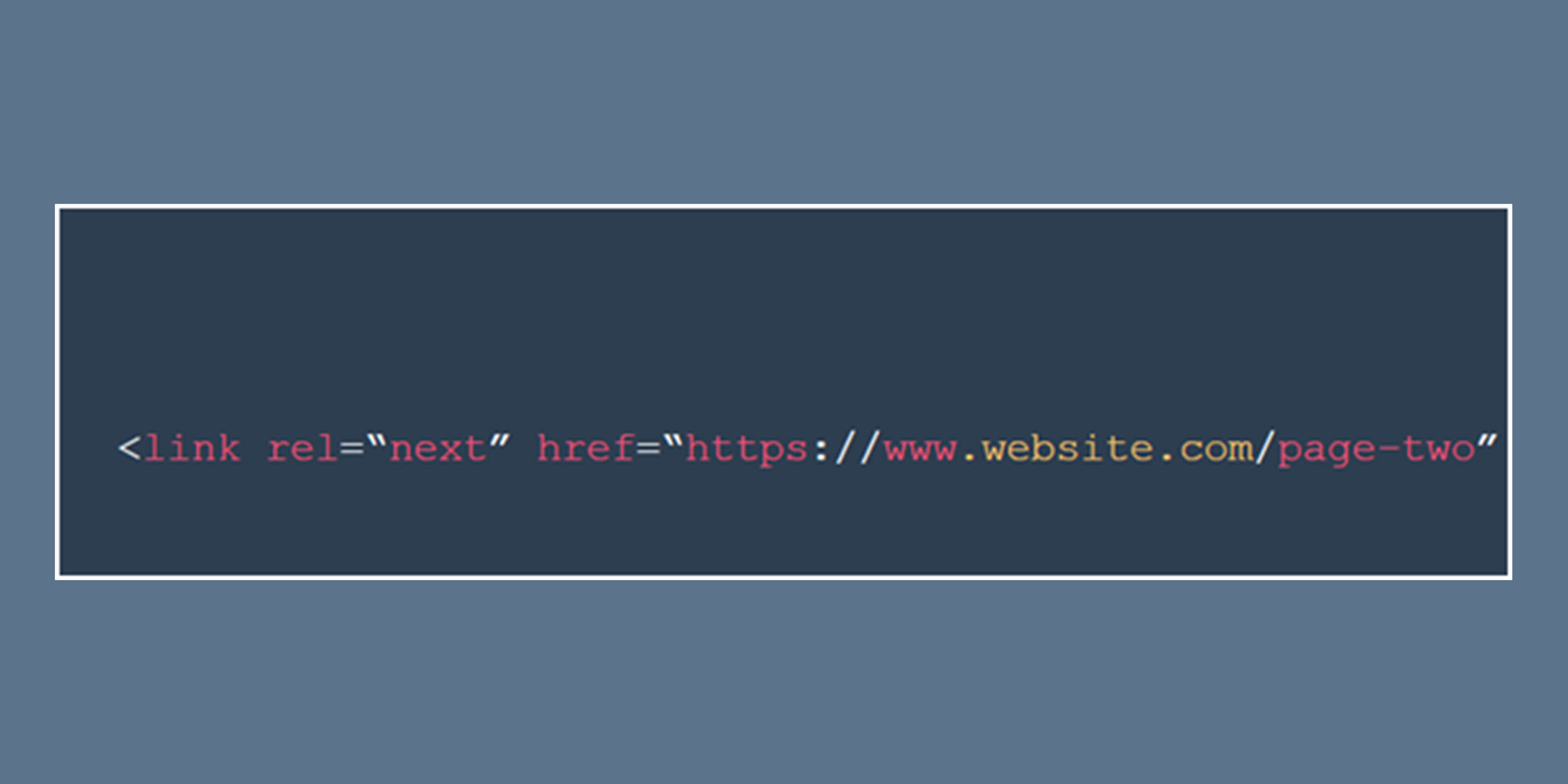

زمانی که شما در سایت تعدادی محتوا دارید که لازم است آنها را در چندین صفحه وب تقسیم کنید، میتوانید از کدهای pagination استفاده کنید.

روش کار بسیار ساده است. به <head> صفحه اول از این سری صفحهها رفته و از کد زیر استفاده کنید:

rel = “next”

تا به رباتها اعلام نمایید که صفحه دیگری در ادامه آمده است. نمونه کد آن در تصویر زیر قابل مشاهده است.

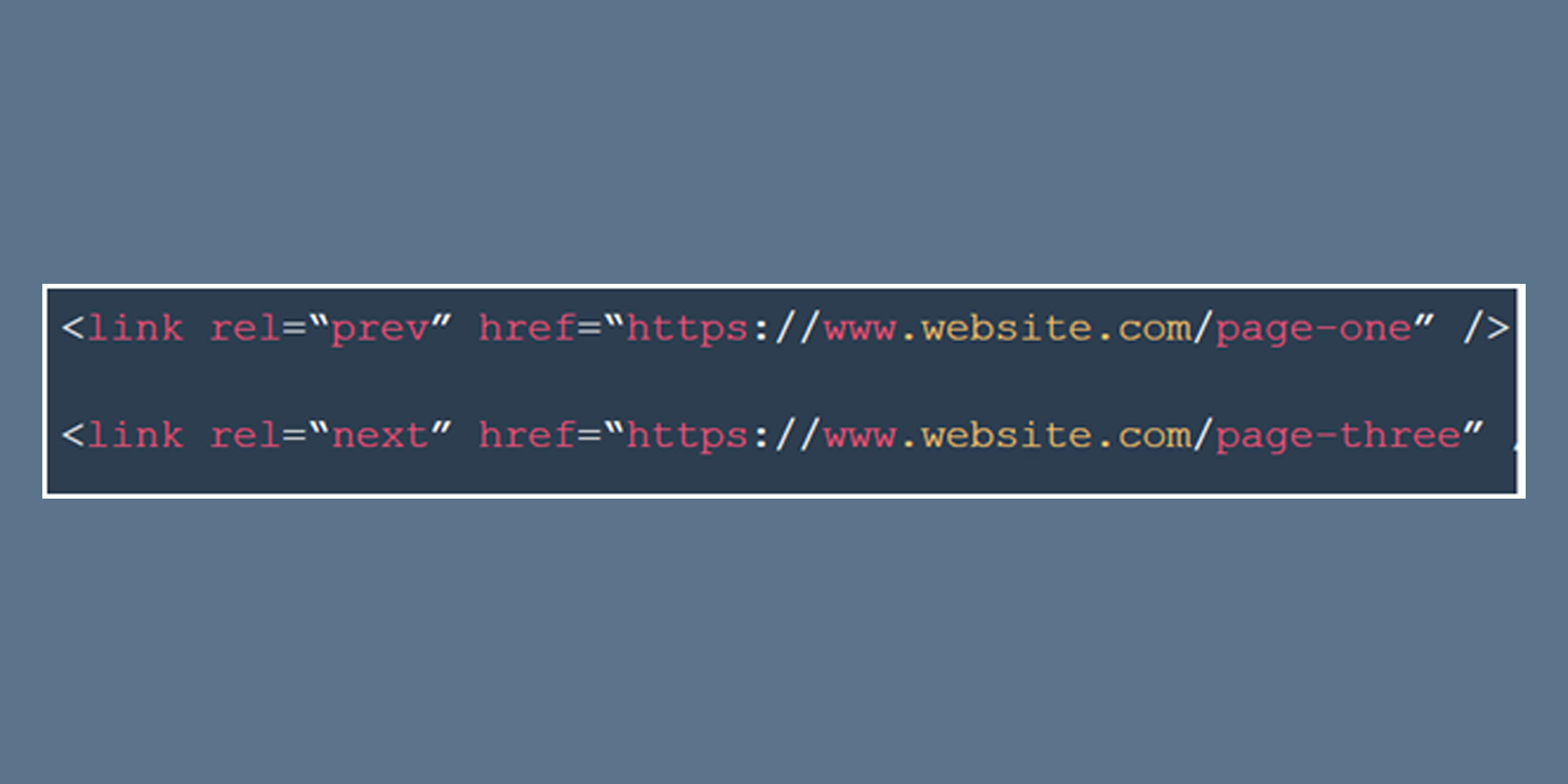

سپس در صفحه دو از rel = “prev” استفاده میکنید تا صفحه قبل را نشان دهید و rel = “next” را برای نشان دادن صفحه بعدی استفاده کنید.

برای صفحه دوم:

فایل log فایلی است که حاوی اطلاعاتی مانند درخواستهای سرور، زمان و مکان درخواستها، آی دی کاربر و URL درخواست شده هستند.

حال که با فایلهای log آشنا شدید، بهتر است کاربرد آن در سئو را نیز بدانید.

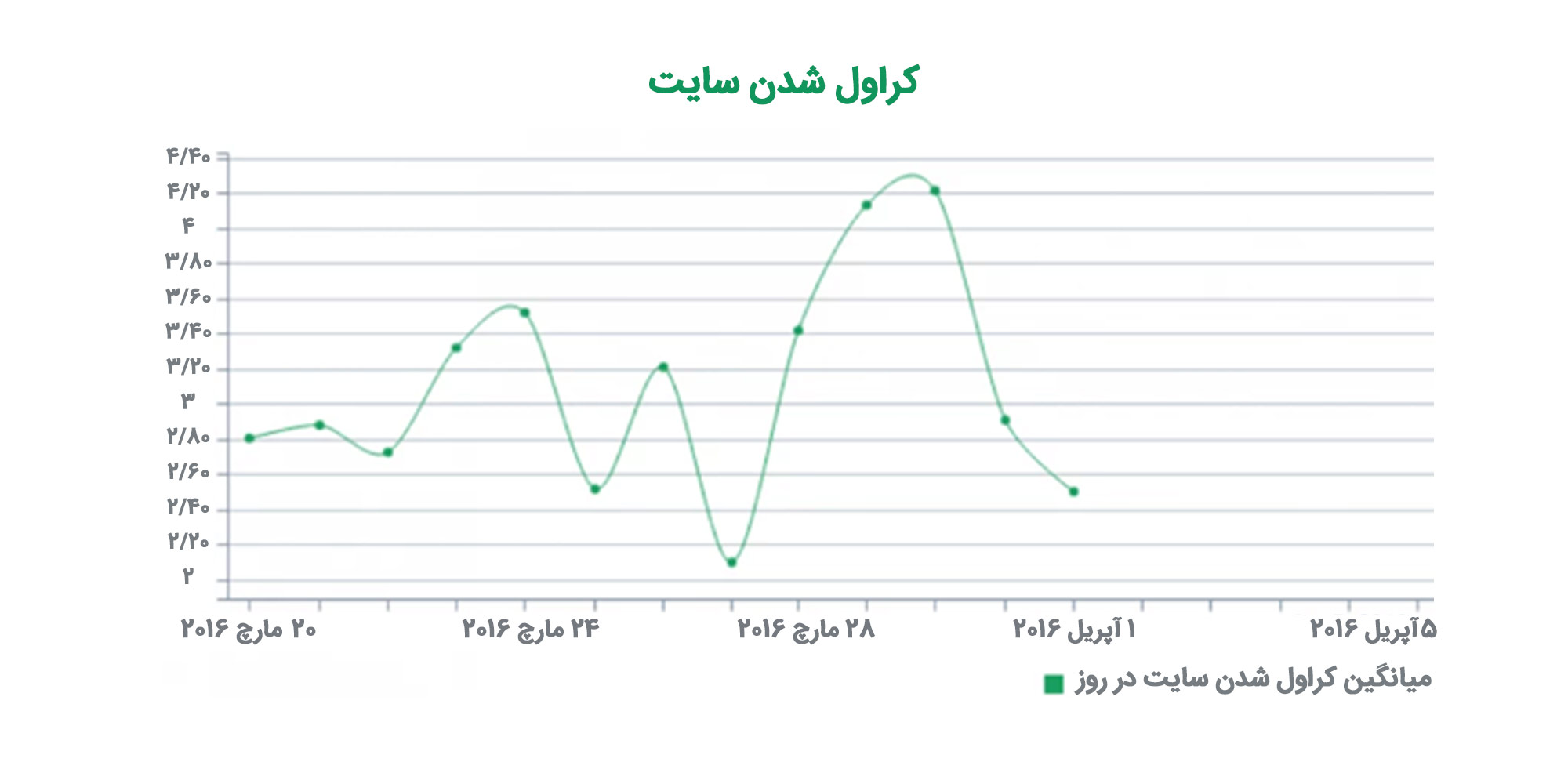

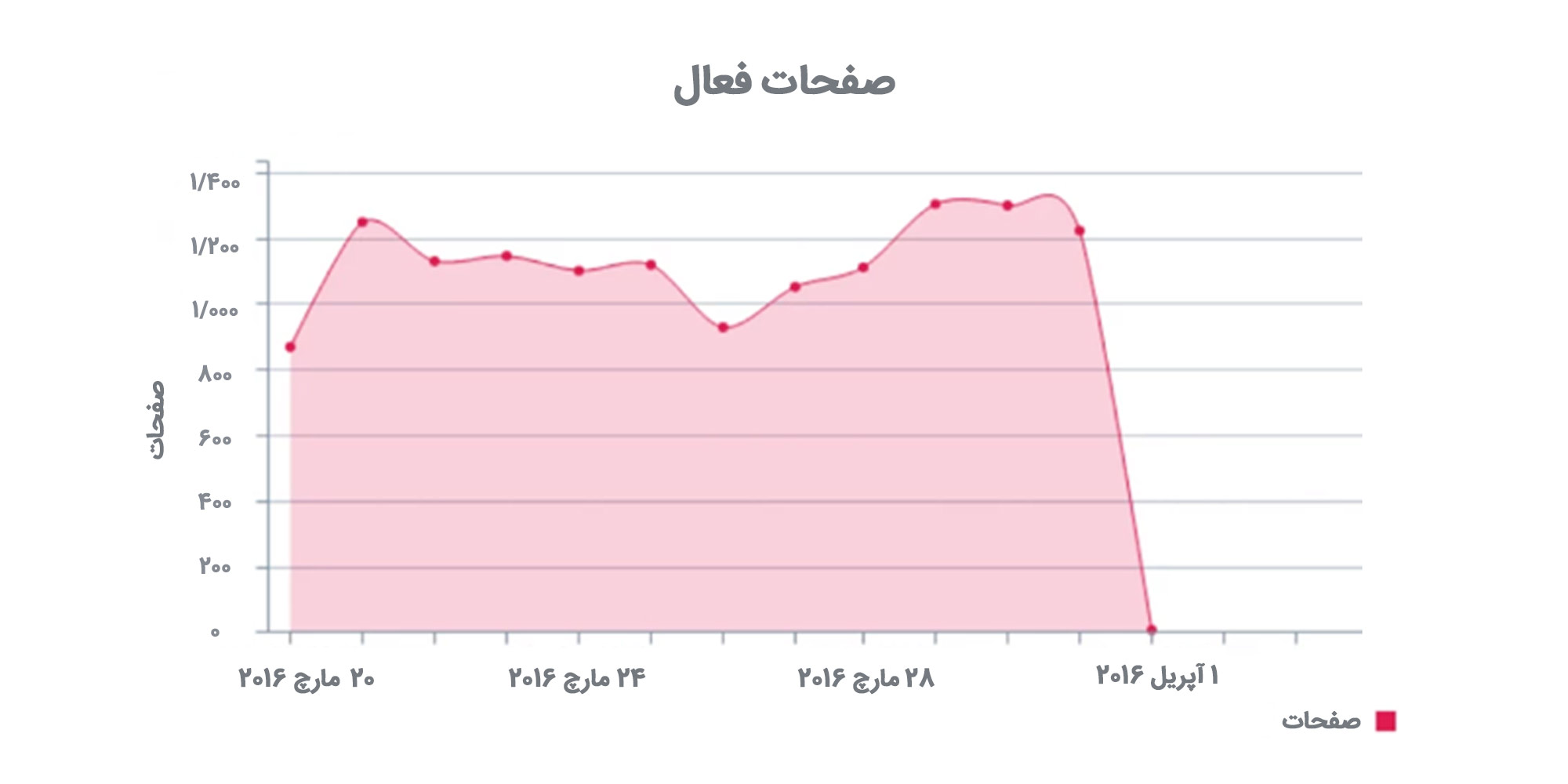

یکی از کاربردهای آن امکان بررسی چگونگی کراول شدن سایت شما است؛ زیرا رباتهای موتور جستجو اثری از خود در فایل log باقی میگذارند. در تصویر زیر به کمک این فایلها میتوان روند کراول شدن سایت را مشاهده کرد.

فایلهای log به شما کمک میکنند تا تعداد بازدید کنندگان جستجوی ارگانیک را بفهمید.

تجزیه و تحلیل فایلهای log میتوانند به ردیابی خطاهایی مانند خطاهای سرور یا خطاهای درون سایت کمک کند. دانستن این خطاها به میزان کروال شدن سایت شما نیز کمک میکند زیرا خطاهایی مانند خطای 404 میزان دفعات کراول شدن را کاهش میدهد.

فایلهای log میتوانند صفحات پرطرفدار شما از نگاه گوگل را مشخص کنند. حتی میتوانید بدانید کراولرها کدام صفحات را به طور معمول میبینند.

شما می توانید از یک آنالیزور ورود به سیستم منبع باز استفاده کنید تا تجزیه و تحلیل فایل log را به صورت رایگان انجام دهید، مانند OnCrawl ELK. این ابزارها به شما کمک میکنند تا اطلاعات زیر را جمعآوری کنید:

hreflangیک تگ HTML است که به موتورهای جستجو میگوید که برای مثال این صفحه، برای زبان یا منطقه جغرافیایی خاصی طراحی شده است. این تگ به ویژه برای وبسایتهای بینالمللی که محتوای خود را به زبانها یا مناطق مختلف ارائه میدهند، بسیار مهم است. با استفاده از hreflang، میتوانید به موتورهای جستجو کمک کنید تا محتوای مناسب را به کاربران بر اساس زبان و مکان جغرافیایی آنها نمایش دهند.

استفاده صحیح از hreflang میتواند به بهبود تجربه کاربری و کاهش نرخ پرش کمک کند؛ زیرا کاربران به نسخهای از سایت هدایت میشوند که به زبان و منطقه آنها نزدیکتر است. همچنین این کار به موتورهای جستجو کمک میکند تا محتوای سایت شما را بهتر درک کنند و رتبه بهتری به صفحات شما دهند.

در این جلسه کلیات سئوی تکنیکال و اهمیت آن شرح داده شد و همچنین با کراول کردن سایت آشنا شدید. در بخش دوم آموزش سئوی فنی به دیگر موارد هرم سئوی فنی میپردازیم و دیگر موارد مهم سئوی تکنیکال را شرح خواهیم داد. در صورتی که تمایل دارید از انتشار بخشهای بعدی مطلع شوید، در خبرنامه بلوک سئو عضو شوید. اگر تجربهای در مورد سئوی فنی و مشکلاتی که برای سایت شما ایجاد کرده است دارید نیز آن را با ما در میان بگذارید.

2 ديدگاه نظر دهيد

تبریک میگم بهتون بابت آموزش زیباتون در مورد سئو و سئوی فنی واقعا جامع و کامل بود دنبال همچین سر فصل ها و آموزش هایی بودم.

مرسی بسیار عالی و بینظیر